インタラクティブロボット研究チーム

研究概要

日常社会で人と共生し、人にさりげない支援を行うロボットの実現を目指して、人とロボットの自然なインタラクションの原理や、人に意識させずに行動変容を促すロボットの振る舞いに関して研究開発を行います。

- 研究分野

- ヒューマンロボットインタラクション

- キーワード

-

- ヒューマノイド

- アンドロイドロボット

- 人間らしい表出

- 自然なインタラクション

- 非言語インタラクション

- マルチモーダルな認識と表出

- 研究テーマ

-

- インタラクションにおける人の振る舞いのモデル化とロボットの自然な動作生成

- マルチモーダル情報に基づく人の状態認識

- 人の無自覚的な行動変容を促すロボットのインタラクティブな動作生成

港 隆史

略歴

- 2001年

- 科学技術振興事業団

- 2002年

- 大阪大学

- 2006年

- 科学技術振興機構

- 2011年

- 国際電気通信基礎技術研究所

- 2020年

- 理化学研究所

受賞歴

- 2016

- 国際電気通信基礎技術研究所 研究開発表彰 優秀研究賞

- 2020

- 国際電気通信基礎技術研究所 研究開発表彰 優秀研究賞

メンバー

- 石井 カルロス 寿憲

- 上級研究員

- 境 くりま

- 研究員

- 内田 貴久

- 研究員

- Bowen Wu

- 基礎科学特別研究員

- 藤井 綺香

- 特別研究員

- 船山 智

- テクニカルスタッフI

- 中山 祐佳

- テクニカルスタッフI

- 神田 崇行

- 客員研究員

- 飯尾 尊優

- 客員研究員

- Chaoran Liu

- 客員研究員

- Jiaqi Shi

- 客員研究員

- 新谷 太健

- 客員研究員

- Zihan Lin

- 研究パートタイマーI兼研修生

- 出口 修大

- 研究パートタイマーI兼研修生

- 浦谷 奈穂美

- 事務パートタイマーI

- 矢野 泰樹

- 研究パートタイマーII兼研修生

- 上野 陽登

- 研究パートタイマーII兼研修生

- Nabeela Khanum Khan

- 研修生

過去のメンバー

- 三方 瑠祐

- テクニカルスタッフI(2022/08-2023/07)

- Changzeng Fu

- 客員研究員(2022/5-2023/3)

- Alexander Diel

- 訪問研究員(2022/07-2023/05)

- Houjian Guo

- 研究パートタイマーII兼研修生(2022/8-2024/3)

- 奥田 にいな

- 研究パートタイマーII兼研修生(2023/06-2025/03)

- 高平 凛

- 研究パートタイマーII兼研修生(2024/05-2025/03)

- 豊田 敦士

- 研究パートタイマーII兼研修生(2024/09-2025/03)

- 田矢 奈実香

- 事務パートタイマーII兼研修生(2022/12-2024/3)

- 松岡 太一

- 事務パートタイマーII兼研修生(2023/6-2024/3)

- 山﨑 真由香

- 事務パートタイマーII兼研修生(2023/06-2025/03)

- Minjeong Bae

- 事務パートタイマーII兼研修生(2023/06-2025/03)

- 堀 勇貴

- 研修生(2020/08-2022/03)

- Simon Andreas Piorecki

- 研修生(2023/12-2024/08)

- 井上 輝也

- 研修生(2024/06-2025/03)

- 佐久間 翔

- インターン(2023/9)

研究成果

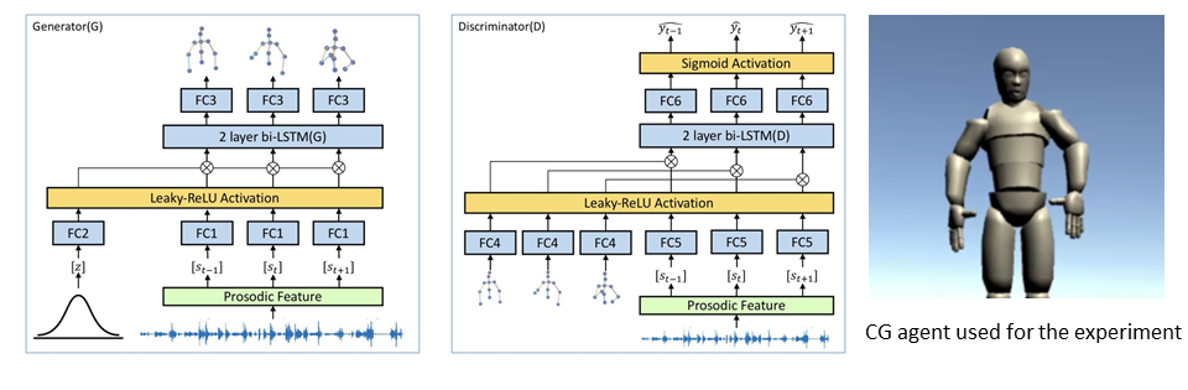

上半身のジェスチャ

インタラクションにおけるロボットの自然な動作生成に関して、ロボットの音声と同期する上半身のジェスチャ生成に取り組んでいます。人が話しながら自然にジェスチャを行ったデータを基に、音声を入力として、韻律特徴を抽出し、それを条件とした Conditional GAN(条件付き敵対的生成ネットワーク) モデルの学習を進めています。これまでに、CGエージェントの発話音声から本手法に基づいて自動的にCGエージェントの動作を生成し、被験者実験を通して人らしい動作が生成されることを確認しています。

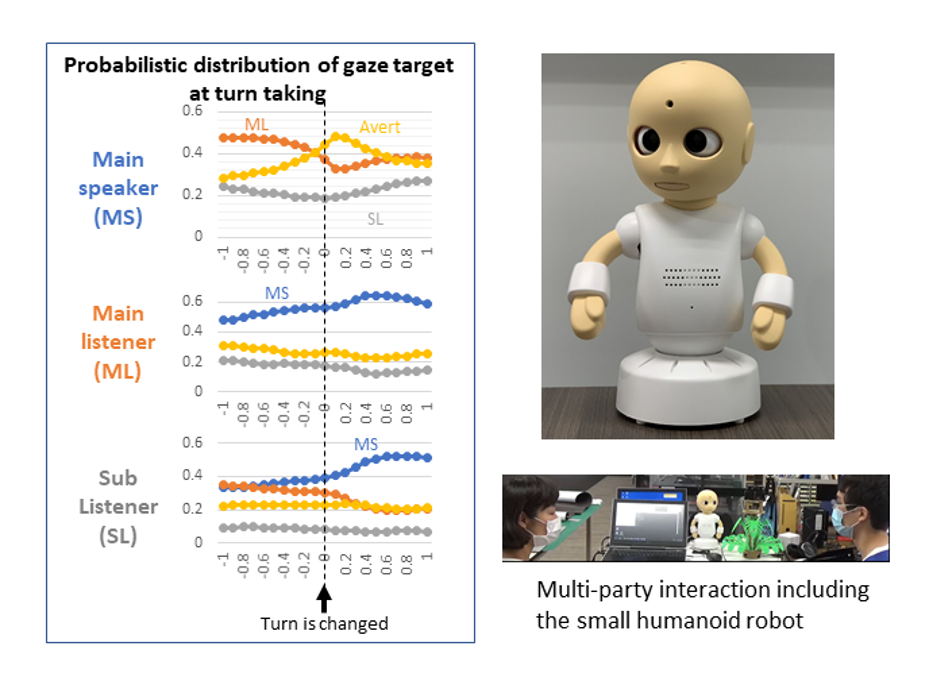

視線制御

インタラクションにおけるロボットの自然な動作生成に関して、ロボットが複数人と対面した対話における視線制御の研究にも取り組んでいます。人同士の複数人対話のデータに基づいて、対話の役割(話者、メインの聞き手、サブの聞き手など)に応じて、視線を合わせる率、視線を逸らす率、視線を逸らす方向の確率密度分布を学習し、視線行動モデルを構築しました。このモデルを小型ロボットの視線制御に実装し、被験者実験を通して、従来法よりも人らしい振る舞いが生成されることを確認しました。

主要論文

-

Taiken Shintani, Carlos T. Ishi, and Hiroshi Ishiguro

Gaze modeling in multi-party dialogues and extraversion expression through gaze aversion control

Advanced Robotics, Vol.38, Issue 19-20 (2024) -

Ird Ali Durrani, Chaoran Liu, Carlos T. Ishi, and Hiroshi Ishiguro

Is it possible to recognize a speaker without listening? Unraveling conversation dynamics in multi-party interactions using continuous eye gaze

IEEE Robotics and Automation Letters, Vol.9, Issue 11, pp.9923-9929 (2024) -

Kazuki Sakai, Koh Mitsuda, Yuichiro Yoshikawa, Ryuichiro Higashinaka, Takashi Minato, and Hiroshi Ishiguro

Effects of demonstrating consensus between robots to change user's opinion

International Journal of Social Robotics (2024) -

Takahisa Uchida, Takashi Minato, and Hiroshi Ishiguro

Opinion Attribution Improves Motivation to Exchange Subjective Opinions with Humanoid Robots

Frontiers in Robotics and AI, Vol.11, No.1175879 (2024) -

Alexander Diel, Wataru Sato, Chun-Ting Hsu, and Takashi Minato

Asynchrony enhances uncanniness in human, android, and virtual dynamic facial expressions

BMC Research Notes, Vol.16, No.368 (2023) -

Tian Ye, Takashi Minato, Kurima Sakai, Hidenobu Sumioka, Antonia Hamilton, and Hiroshi Ishiguro

Human-like interactions prompt people to take a robot's perspective

Frontiers in Psychology, Vol.14, No.1190620 (2023) -

Alexander Diel, Wataru Sato, Chun-Ting Hsu, and Takashi Minato

Differences in configural processing for human versus android dynamic facial expressions, Scientific Reports, Vol.13, No. 16952, 2023. -

Bowen Wu, Chaoran Liu, Carlos T. Ishi, Jiaqi Shi, and Hiroshi Ishiguro

Extrovert or introvert? GAN-based humanoid upper-body gesture generation for different impressions

International Journal of Social Robotics (2023) -

Alexander Diel, Wataru Sato, Chun-Ting Hsu, and Takashi Minato

The inversion effect on the cubic humanness-uncanniness relation in humanlike agents

Frontiers in Psychology, Vol.14, No.1222279, (2023) -

Carlos T. Ishi, Chaoran Liu, and Takashi Minato

An attention-based sound selective hearing support system: evaluation by subjects with age-related hearing loss

Proc. of IEEE/SICE International Symposium on System Integrations, 2023. -

Xinyue Li, Carlos T. Ishi, and Ryoko Hayashi

Prosodic and voice quality analyses of filled pauses in Japanese spontaneous conversation by Chinese learners and Japanese native speakers

Proc. of International Conference on Speech Prosody, 2022. -

Dongsheng Yang, Qianying Liu, Takashi Minato, Shushi Namba, and Shin'ya Nishida

Optimizing facial expressions of an android robot effectively: a Bayesian optimization approach

Proc. of IEEE-RAS International Conference on Humanoid Robots, 2022. -

Takashi Minato, Kurima Sakai, Takahisa Uchida, and Hiroshi Ishiguro

A study of interactive robot architecture through the practical implementation of conversational android

Frontiers in Robotics and AI, Vol.9, No.905030, 2022. -

Changzeng Fu, Chaoran Liu, Carlos T. Ishi, and Hiroshi Ishiguro

C-CycleTransGAN: A non-parallel controllable cross-gender voice conversion model with CycleGAN and Transformer

Proc. of Asia Pacific Signal and Information Processing Association Annual Summit and Conference, 2022. -

Taiken Shintani, Carlos T. Ishi, and Hiroshi Ishiguro

Expression of personality by gaze movements of an android robot in multi-party dialogues

Proc. of IEEE International Conference on Robot and Human Interactive Communication, 2022. -

Changzeng Fu, Chaoran Liu, Carlos T. Ishi, and Hiroshi Ishiguro

An adversarial training based speech emotion classifier with isolated Gaussian regularization

IEEE Transactions on Affective Computing, Vol.14, No.8, 2022. -

Bowen Wu, Jiaqi Shi, Chaoran Liu, Carlos T. Ishi, and Hiroshi Ishiguro

Controlling the impression of robots via GAN-based gesture generation

Proc. of IEEE/RSJ International Conference on Intelligent Robots and Systems, 2022. -

Wataru Sato, Shushi Namba, Dongsheng Yang, Shin'ya Nishida, Carlos T. Ishi, and Takashi Minato

An android for emotional interaction: Spatiotemporal validation of its facial expressions

Frontiers in Psychology, Vol.12, 2022. -

Jiaqi Shi, Chaoran Liu, Carlos T. Ishi, and Hiroshi Ishiguro

3D skeletal movement-enhanced emotion recognition networks

APSIPA Transactions on Signal and Information Processing, Vol.10, No.E12, 2021.

関連リンク

お問い合わせ先

takashi.minato [at] riken.jp

※[at]は@に置き換えてください。